G検定対策!「Attentionとトランスフォーマー」がわかる学習ノート

1. Transformerとは?

Transformer(トランスフォーマー)は、2017年に発表されたAIモデル(設計図)の名前です。もともとは機械翻訳のために開発されましたが、その仕組みがあまりに強力だったため、現在では Gemini や GPT のようなチャットAIや、画像認識など、あらゆるAIの「標準エンジン」として使われています。

2. なぜTransformerはすごいのか?

それは「Attention (アテンション)」という画期的な仕組みを使っているからです。

以前のAI (RNN) の課題

- RNN (Recurrent Neural Network) は、「順番」を気にするAIでした。

- 例え: 情報を「伝言ゲーム」で順番に伝えていく方式。

- 課題: 文章が長くなると、最初の方の重要な情報(例:主語)を忘れてしまう「忘れっぽい」という弱点がありました。

Transformerの解決策

- Attention (アテンション) は、「全体ミーティング」方式です。

- 文章の全単語を一度に集め、「今、どの単語が一番関係が深いか?」を瞬時に見抜きます。

- メリット: どんなに離れた単語同士でも(例:文頭の主語と文末の動詞)、直接関係性を確認できるため、長い文章でも情報を忘れません。

3. Transformerを支える重要な仕組み

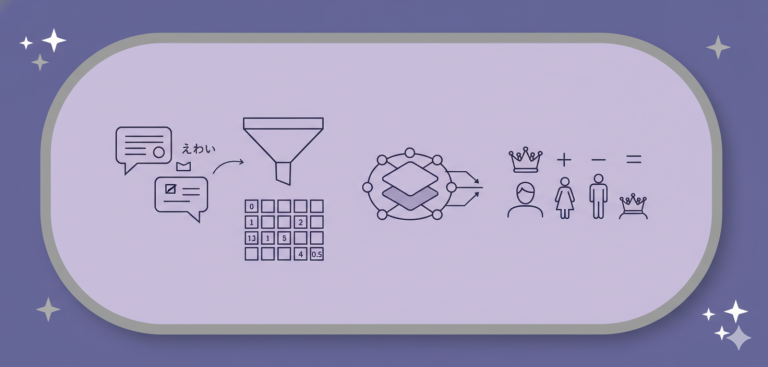

① Self-Attention (セルフ・アテンション)

- 「自己(Self)注目」という意味です。

- 「私は公園で犬と遊んだ」という1つの文章(=自分)の中で、「『遊んだ』に一番関係があるのは『私』と『犬』だな」と、AIが自分自身の内部で関係性を見つける仕組みです。

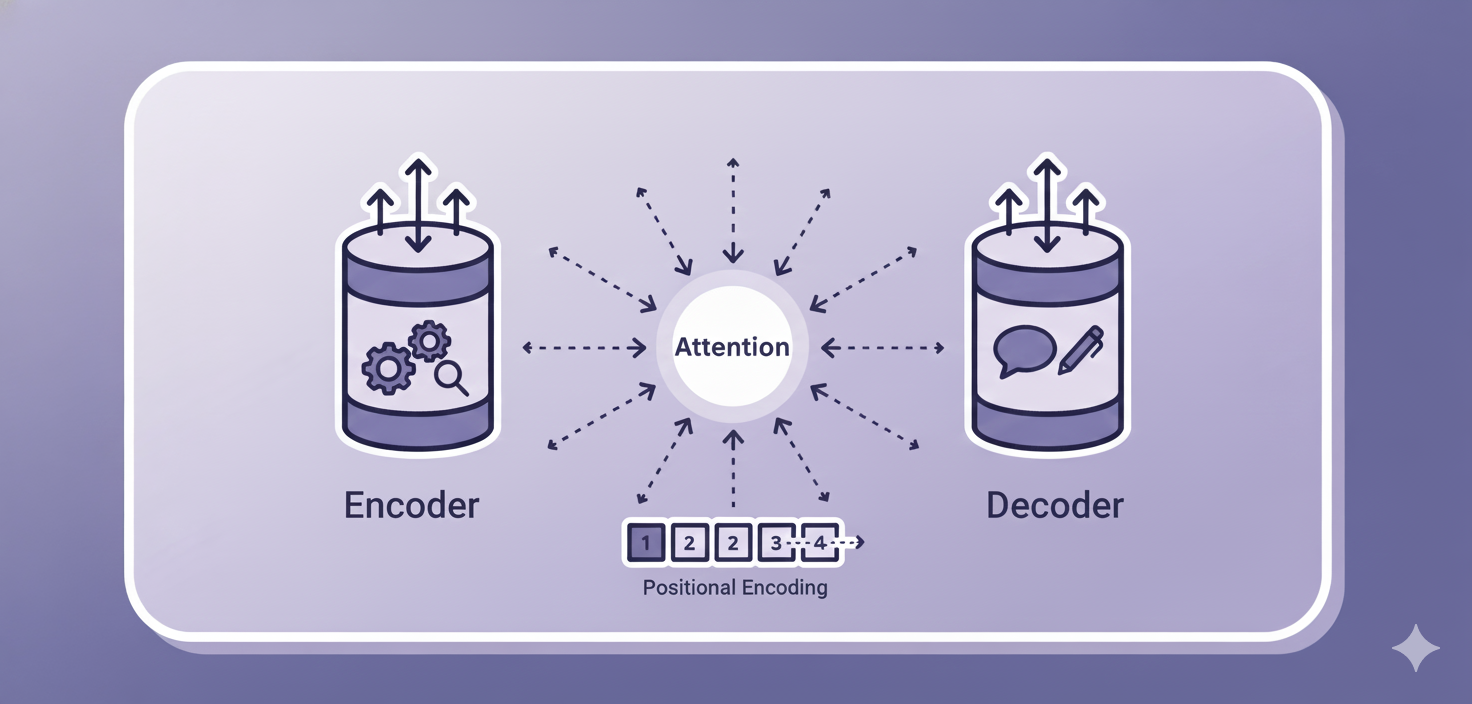

② 位置エンコーディング (Positional Encoding)

- Self-Attentionの弱点を補う仕組みです。

- 「全体ミーティング」方式では、単語の「順番」の情報が失われてしまいます。(例:「犬が猫を追いかけた」と「猫が犬を追いかけた」の区別がつかない)

- そこで、AIに情報を読み込ませる前に、各単語に「1番目」「2番目」…というゼッケン番号(=位置情報)を貼り付けます。

- これにより、AIは「関係性」と「順番」の両方を理解できるようになります。

③ Multi-Head Attention (マルチヘッド・アテンション)

- Attention(注目)を、複数の視点で同時に行う仕組みです。

- 例え: ミーティングを「分科会」に分けること。

- A分科会:「誰がやったか」に注目

- B分科会:「どこでやったか」に注目

- これにより、1つの文章が持つ「文法的な関係」や「場所の関係」など、多角的な意味をより深く理解できます。

4. Transformerの「2つのタワー」と使い分け

Transformerの基本設計は、「エンコーダ(理解タワー)」と「デコーダ(作成タワー)」の2つで構成されます。

① エンコーダ (Encoder)

- 役割: 入力された文章(お手本)の意味を深く理解する専門家。

- 主な仕組み: Self-Attention を使います。

- 使われ方 (BERTなど): エンコーダだけを使い、「文章の穴埋めクイズ(Masked LM)」を解かせることで、文章の読解が得意なAIになります。

② デコーダ (Decoder)

- 役割: 新しい文章をゼロから作成する専門家。

- 主な仕組み:

- Self-Attention(自分が今までに書いた文章を振り返る)

- Source-Target Attention(お手本(Source)をカンニングする)

- 使われ方 (GPT, Geminiなど): デコーダだけを使い、「次の単語を予測する」勉強をさせることで、自然なチャットや文章作成が得意なAIになります。

※機械翻訳モデル

- G検定の教科書に出てくる基本形です。

- エンコーダ(お手本理解)とデコーダ(文章作成)の両方を使います。デコーダがエンコーダの理解結果をカンニング(Source-Target Attention)しながら翻訳文を作ります。